Sensori di visione artificiale:

Come le macchine vedono il mondo

La produzione implica l'approvvigionamento delle parti giuste, la ricerca di uno stabilimento adatto, la realizzazione dei progetti in tempo utile per la catena di montaggio e la gestione delle sfide di conformità e sicurezza necessarie per scalare a livello globale.

L’ideale sarebbe impiegare la tecnologia di automazione per migliorare le linee di produzione e i prodotti che ne derivano con un'elevata efficienza. Gli input visivi sono la fonte più ricca di informazioni dei sensori. Gli sviluppi della visione nel settore manifatturiero consentono di migliorare l'affidabilità e la qualità dei prodotti, oltre a rendere possibile la tecnologia di un nuovo processo produttivo. Parleremo di come la visione artificiale viene utilizzata nell'automazione industriale per facilitare il processo di produzione.

Nell'automazione industriale, i sensori vengono utilizzati per raccogliere dati da ispezionare o per attivare altri dispositivi. Questi sensori rientrano in diverse categorie: fotoelettrici, a fibra ottica, di prossimità, a ultrasuoni e di visione sono i più comuni. Questi sensori non sono in grado di distinguere tra modelli o colori e, grazie alla loro rigida configurazione di montaggio, non possono gestire il disallineamento o la variabilità. I sensori di visione si distinguono per la loro maggiore flessibilità, per l'esecuzione di più tipi di ispezione in un'unica immagine e per la generazione di dati aggiuntivi per il miglioramento della qualità e dei processi.

Fusione dei sensori

Gli sviluppatori di automazione hanno bisogno di una serie di sensori che forniscano dati grezzi e feedback, sistemi di controllo, logica programmabile e dispositivi embedded collegati. I dati vengono analizzati da un algoritmo e non da una persona: questo offre l'opportunità di introdurre diverse modalità di rilevamento nei sistemi di visione artificiale. Queste possono includere modalità diverse dai sensori di immagine, come il tempo di volo, il radar e il Lidar. Da qui nasce l'esigenza di una fusione di sensori. La fusione dei sensori è il processo che consiste nel prendere dati da più fonti e combinarli in un unico insieme che possa essere inserito in una rete neurale. Si tratta di una fase cruciale, perché il modo in cui i dati di ciascun sensore vengono ponderati influisce sulla loro rilevanza nel set di dati finale.

Sistemi di visione artificiale

La visione artificiale è il campo dell'intelligenza artificiale (AI) che permette alle macchine di "vedere"; combinando i sistemi embedded con la visione artificiale si ottengono sistemi di visione artificiale/embedded. La tecnologia di visione artificiale (MV) è ben posizionata nell'Industrial Internet of Things (IIoT), dove macchine di ogni tipo sono costantemente connesse. La visione artificiale viene adottata così rapidamente per le applicazioni IIoT grazie alla crescente convenienza dei componenti e dei sistemi di visione artificiale, a una gamma più ampia di soluzioni, a un hardware migliore e a un software basato sull'intelligenza artificiale per le capacità di apprendimento profondo. Il sistema di visione artificiale ha la capacità di elaborare una grande quantità di informazioni in una frazione di secondo.

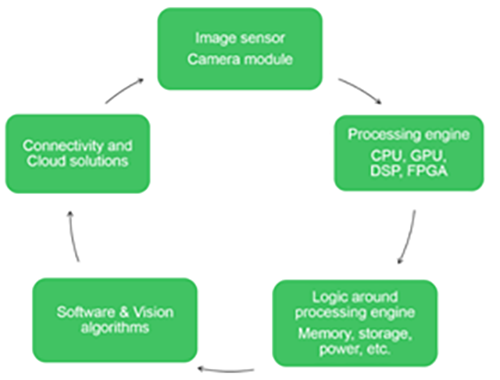

In linea di massima, i diversi tipi di sistemi di visione comprendono i sistemi di visione 1D, i sistemi di visione 2D, i sistemi di scansione lineare o di area e i sistemi di visione 3D. I principali blocchi funzionali di un tipico sistema di visione (figura 1) sono l'unità di acquisizione delle immagini (sensore di immagine/modulo fotocamera), l'unità di elaborazione, la segmentazione e il software e gli algoritmi di visione/riconoscimento dei modelli e connettività.

Figura 1: Elementi costitutivi della visione artificiale

La visione artificiale utilizza delle telecamere che catturano le informazioni visive dall'ambiente circostante, come fossero occhi. La risoluzione e la sensibilità sono due aspetti importanti di qualsiasi sistema di MV. La risoluzione è responsabile della differenziazione tra gli oggetti, mentre la sensibilità è la capacità della macchina di rilevare oggetti o impulsi deboli nonostante le luci fioche o le lunghezze d'onda invisibili.

I componenti principali del sistema comprendono illuminazione, lenti, sensori di immagine, elaborazione della visione e dispositivi di comunicazione; spesso si utilizzano ottiche specializzate per acquisire le immagini. La tecnologia MV è una combinazione di software e hardware che fornisce il controllo operativo ai dispositivi che eseguono funzioni come l'acquisizione e l'elaborazione di immagini e la misurazione di varie caratteristiche necessarie per prendere decisioni. I componenti hardware comprendono diversi oggetti come telecamere, sensori, processori, frame grabber, luci LED e ottiche. Il segmento dell'offerta software è suddiviso in sottocategorie di software MV per applicazioni specifiche e software MV per l'apprendimento profondo.

I fornitori di sistemi di visione artificiale offrono principalmente due tipi di servizi: l'integrazione e la gestione delle soluzioni. Gli integratori di sistemi di visione industriale sono utilizzati per applicazioni di ispezione, collaudo, assemblaggio e misurazione e aiutano i clienti a soddisfare le specifiche dei loro prodotti. La gestione delle soluzioni viene utilizzata per le operazioni di debug in un unico passaggio, per il controllo delle ispezioni (avvio e arresto) e per le soluzioni di apertura e salvataggio.

Scegliere l'hardware giusto

Esistono molte opzioni per decidere l'hardware che dovrà gestire la tua applicazione di intelligenza artificiale per la visione artificiale. Gli FPGA (Field Programmable Gate Array), le unità di elaborazione grafica (GPU) e persino i microcontrollori (MCU) presentano ciascuno i propri vantaggi.

Le FPGA sono unità di elaborazione molto potenti che possono essere configurate per soddisfare i requisiti di quasi tutte le applicazioni. È possibile creare architetture FPGA su misura per gestire applicazioni specifiche. Le FPGA raggiungono prestazioni molto più elevate, costi inferiori e una migliore efficienza energetica rispetto ad altre opzioni come le GPU e le CPU. Le GPU sono processori specializzati, progettati principalmente per elaborare immagini e video. Rispetto alle CPU, si basano su unità di elaborazione più semplici ma ospitano un numero molto maggiore di core. Questo le rende eccellenti per le applicazioni che richiedono l'elaborazione in parallelo di grandi quantità di dati, come i pixel delle immagini o i codec video. Le CPU hanno un numero limitato di core, il che impedisce loro di elaborare rapidamente le grandi quantità di dati necessarie per l'intelligenza artificiale.

Sensore di immagine e illuminazione

Quando si sviluppa un sistema di visione artificiale, la scelta del giusto sensore di immagine potrebbe essere una delle decisioni di progettazione più importanti. Il progetto richiede l'acquisizione di immagini ad alta risoluzione, il trasferimento veloce dei dati con un rumore minimo e una potenza di elaborazione efficiente in grado di elaborare i dati e generare output. I progressi nell'illuminazione front-side (FSI) e back-side (BSI) della tecnologia dei sensori CMOS consentono di ottenere immagini ad alta risoluzione anche in condizioni di scarsa illuminazione.

Anche un'illuminazione adeguata è un aspetto importante. Le prestazioni di illuminazione si basano tutte su tre caratteristiche principali del sensore di immagine: efficienza quantica (QE), corrente oscura e capacità di saturazione. Quando viene implementata in una telecamera, la QE massima di quest’ultima deve essere inferiore a quella del sensore, per via di effetti ottici ed elettronici esterni.

Anche la corrente oscura e la capacità di saturazione sono importanti considerazioni di progettazione nei sistemi di visione artificiale. La corrente oscura misura la variazione del numero di elettroni generati termicamente all'interno del CMOS imager e può aggiungere rumore. La capacità di saturazione indica il numero di elettroni che un singolo pixel può immagazzinare. Possono essere utilizzati con le misurazioni QE per ricavare il massimo rapporto segnale/rumore (S/N), la sensibilità assoluta e la gamma dinamica di un'applicazione.

L'illuminazione giusta contribuisce ad aumentare l'accuratezza e l'efficienza di un'applicazione di visione industriale. Altri fattori da considerare per l'illuminazione sono la lunghezza d'onda, come gli infrarossi, l'illuminazione fissa e anche la collocazione dell'illuminazione. È stato dimostrato che le fonti di luce e i riflessi che illuminano direttamente le telecamere dei sistemi di visione industriale riducono la precisione del rilevamento degli oggetti.

Scegliere la giusta telecamera per la visione artificiale

I recenti progressi della tecnologia di visione industriale consentono alle telecamere di trasferire immagini ad alta risoluzione a velocità estremamente elevate. La scelta dell'interfaccia migliore richiede un esame di diverse considerazioni, come la scelta del tipo di sensore (CMOS o CCD), della telecamera a colori o monocromatica, del formato di uscita della telecamera (GigE, Camera Link, CoaXPress, USB3, HD-SDI) e della frequenza dei fotogrammi. I CCD hanno una qualità d'immagine superiore, una migliore sensibilità alla luce, una maggiore silenziosità e un otturatore globale ideale. I sensori CMOS sono noti per l'alta velocità, l'integrazione del sistema on-chip e il basso costo di produzione.

I produttori di telecamere sfruttano gli ultimi sviluppi dei sensori e i miglioramenti nella progettazione delle telecamere, aiutando gli sviluppatori e gli integratori di sistemi di visione artificiale a creare sistemi di imaging più veloci, flessibili e capaci. Con l'aumento delle risoluzioni delle telecamere si rende necessaria l'adozione di ottiche di qualità superiore e di formato più grande, che sono facilmente disponibili, con opzioni che includono lenti liquide incorporate per i sistemi di messa a fuoco automatica. Le ottiche per le lunghezze d'onda non visibili consentono nuovi modi di rilevare le cose con un imaging specializzato che utilizza lunghezze d'onda che vanno dall'UV alle bande IR.

I prodotti di illuminazione a LED, fondamentali per tutte le applicazioni di visione industriale, sono ora disponibili in un'ampia gamma di lunghezze d'onda e fattori di forma. Sono caratterizzati da una maggiore flessibilità, con angoli sintonizzabili e lunghezze d'onda aggiuntive, una risposta spettrale più coerente e persino sorgenti programmabili con controlli incorporati. Un fattore importante è la comparsa di interfacce fino a 100 G, oltre all'interfaccia CoaXPress 2.0 recentemente aggiornata e alle interfacce PCI.

Scegliere un obiettivo per la visione artificiale

La scelta dell'obiettivo giusto per un'applicazione di visione industriale richiede una revisione delle specifiche richieste, un po' di matematica e una considerazione su come l'obiettivo si integrerà con la configurazione della telecamera. Quando si sceglie l'obiettivo da utilizzare in un'applicazione di visione industriale, bisogna considerare il sensore che verrà utilizzato. Le dimensioni del sensore e dei pixel sono di estrema importanza nel processo di selezione. L'obiettivo deve essere in grado di illuminare correttamente l'intera area del sensore per evitare ombreggiature e vignettature.

Gli obiettivi ideali producono immagini che corrispondono perfettamente all'oggetto ripreso, compresi tutti i dettagli e le variazioni di luminosità. Gli obiettivi standard possono essere di circa un megapixel con lunghezze focali fisse di 4,5-100 mm. Gli obiettivi macro sono ottimizzati per la messa a fuoco da vicino. Quando scelgono l'obiettivo giusto per un'applicazione, i progettisti calcolano la distanza di lavoro necessaria utilizzando 3 fattori: la lunghezza focale, la lunghezza dell'oggetto da ispezionare e le dimensioni del sensore.

Alcuni casi d'uso/scenari applicativi

I sistemi di visione artificiale nell'industria alimentare e delle bevande sono utilizzati soprattutto nelle operazioni di confezionamento e imbottigliamento. Probabilmente i sistemi di visione artificiale registreranno una crescita significativa nei settori farmaceutico e chimico, della stampa e dell'etichettatura e in altri settori verticali, tra cui l'agricoltura, la lavorazione della gomma e della plastica, i pannelli solari, i macchinari e le attrezzature, la sicurezza e la sorveglianza. Il mercato è stato segmentato in garanzia di qualità e ispezione, posizionamento e guida, misurazione e identificazione. I sistemi sono ampiamente utilizzati per la scansione e l'identificazione di etichette, codici a barre e testi, soprattutto nel settore dell'imballaggio. In questo modo si automatizzano le attività di imballaggio, risparmiando tempo, evitando errori umani e aumentando l'efficienza.

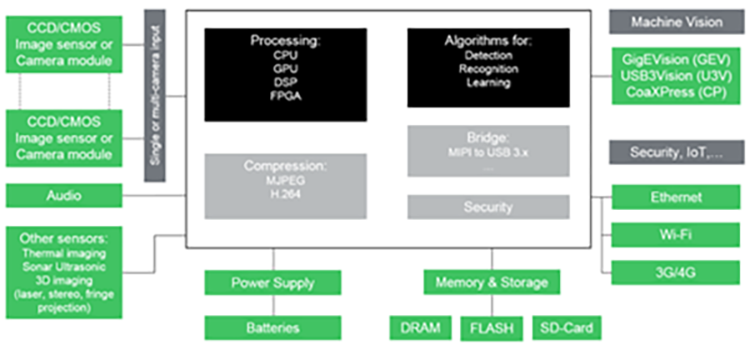

Le soluzioni di visione artificiale rendono i processi produttivi più efficienti e competitivi. Le telecamere MV funzionano perfettamente in un'ampia gamma di ambienti di produzione. Il tipico blocco applicativo è illustrato nella Figura 2.

Figura 2: Tipico blocco applicativo per la visione artificiale

Piattaforma di visione intelligente di Avnet Integrated

Avnet ha sviluppato piattaforme di sviluppo modulari specifiche per la visione embedded, che combinano telecamere intelligenti, tecnologie informatiche basate su edge o cloud, software e intelligenza artificiale per la realizzazione di sistemi in grado di rilevare e identificare persone e oggetti. La piattaforma tecnologica di visione intelligente integrata di Avnet (Figura 3) è stata progettata per l'analisi video supportata dal deep learning sull'edge. Questo progetto è stato realizzato in collaborazione con i principali fornitori di processori, sensori di immagine e strumenti software per integrare i loro prodotti in una soluzione coesa.

Figura 3: Piattaforma di visione con tecnologia AI di Avnet - Infinity® AI Cube

Per queste applicazioni ad alte prestazioni, la piattaforma di visione intelligente è dotata del potentissimo modulo COM Express™ Type 6 della famiglia MSC C6B-CFLR di Avnet Integrated, basato su un processore Intel® Core i7 o Intel® Xeon™.

La piattaforma tecnologica può integrare diverse tecnologie di accelerazione per un'elaborazione veloce dei dati sull'edge. A seconda dell'applicazione specifica, il numero di canali video e il tempo di latenza giocano un ruolo importante. Le soluzioni vanno dall'inferenza AI su potenti CPU, alle unità di elaborazione grafica fino alle ottimizzate Intel® Movidius Vision Processing Units (VPU).